Wpadki AI / Gdy sztuczna inteligencja wymyka się spod kontroli

Sztuczna inteligencja rewolucjonizuje wszystkie branże, oferując naprawdę imponujące możliwości w zakresie wydajności, szybkości i innowacyjności. Jednak w miarę jak systemy AI stają się coraz bardziej zintegrowane z procesami biznesowymi, staje się oczywiste, że narzędzia te nie są również pozbawione wad.

Od małych błędów po poważne problemy etyczne — usterki i awarie sztucznej inteligencji ukazują, jak wrażliwe są te systemy. Biznes musi pozostać czujny i na bieżąco wyciągać wnioski z niepowodzeń AI, aby uniknąć kosztownych błędów w przyszłości. Podstawą udanego wejścia w świat sztucznej inteligencji jest odpowiednie przygotowanie infrastruktury danych oraz zapewnienie cyberbezpieczeństwa. Nie możemy także absolutnie zapominać o ugruntowanych zasadach etycznych.

Dlaczego projekty AI zawodzą / Problem z danymi

Jedną z kluczowych przyczyn niepowodzeń AI jest niska jakość danych. Badania pokazują, że nawet 85% projektów AI kończy się niepowodzeniem (link). Systemy AI są tak dobre, jak dane, na których są szkolone. Korzystanie z wadliwych, niekompletnych lub stronniczych zestawów danych prowadzi do niewiarygodnych wyników. Bez oczyszczonych uporządkowanych danych nawet najbardziej zaawansowane modele sztucznej inteligencji nie mogą zapewnić spójnych wyników. Ich wysoka jakość jest szczególnie istotna w krytycznych sektorach, takich jak opieka zdrowotna, autonomiczna jazda i badania prawne. Aby biznes mógł z powodzeniem wdrażać sztuczną inteligencję, klucz do sukcesu stanowi zapewnienie najwyższej staranności w dbałości o wiarygodność zbiorów danych.

Nauka na błędach AI / W kierunku bezpiecznej przyszłości

Aby ograniczyć ryzyka, firmy muszą inwestować w solidne rozwiązania do przechowywania danych, zabezpieczać je i skupiać się na eliminowaniu uprzedzeń w modelach AI. Nadzór ludzki pozostaje kluczowy w zapobieganiu popełniania szkodliwych błędów przez sztuczną inteligencję. Ponadto nie można przecenić znaczenia ochrony procesów AI za pomocą bezpiecznej infrastruktury danych. Koncentrując się na jakości danych, etycznym rozwoju sztucznej inteligencji i ciągłym monitorowaniu, firmy mogą uniknąć najczęstszych pułapek związanych ze sztuczną inteligencją, w pełni wykorzystując potencjał tych systemów w odpowiedzialny sposób — minimalizując ryzyko i maksymalizując korzyści w długoterminowej perspektywie.

Rozwój sztucznej inteligencji / Od obietnic do pułapek

Systemy uczenia maszynowego i generatywnej AI na stałe wpisały się w różne sektory światowej gospodarki. Sztuczna inteligencja to z jednej strony game changer w historii światowej gospodarki, a z drugiej – kruche (w kontekście wrażliwości na zmianę parametrów oraz niską wyjaśnialność) i złożone narzędzie, z którym należy się obchodzić jak z jajkiem.

Jakie zatem konkretnie błędy, awarie i porażki AI mogą się kryć pod tą jakże kuszącą obietnicą technologiczną, jaką jest AI?

Dziś opowiemy Wam o kilku takich przypadkach.

Halucynacje AI / Kiedy Chatboty AI tworzą swój własny świat

Jednym z najbardziej zagadkowych i jednocześnie niepokojących aspektów systemów sztucznej inteligencji jest ich tendencja do halucynacji, tj. tworzenia informacji, które są całkowicie wyssane z palca. Zjawisko to jest szczególnie rozpowszechnione w dużych modelach językowych (LLM) oraz napędzanych przez nie rozwiązaniach, np. chatbotach AI.

Konsekwencje halucynacji AI

W sprawie dotyczącej niewłaściwego wykorzystania sztucznej inteligencji dwóch prawników i ich kancelaria prawna Levidow, Levidow & Oberman, P.C., zostali ukarani grzywną w wysokości 5000 USD po przedstawieniu fikcyjnych spraw prawnych wygenerowanych przez chatbota AI. Incydent miał miejsce podczas roszczenia o odszkodowanie lotnicze przeciwko Avianca Airlines z Kolumbii. Prawnicy, szukając precedensów prawnych, zwrócili się do chatbota AI, który dostarczył im nieistniejące orzeczenia sądowe. Pomimo sygnałów ostrzegawczych mecenasi nadal opierali się na sfabrykowanych sprawach, nawet po tym, jak sędzia wyraził obawy co do ich ważności. Arbiter w sprawie, P. Kevin Castel, stwierdził, że prawnicy działali w złej wierze, przedstawiając fałszywe informacje, a następnie broniąc ich dokładności, gdy zostały zakwestionowane.

Chociaż sędzia Castel przyznał, że narzędzia technologiczne, takie jak chatbot AI, mogą być przydatne, podkreślił, że prawnicy są odpowiedzialni za zapewnienie dokładności wszelkich informacji, które przekazują sądowi. Zauważył, że mecenasi nie zareagowali odpowiednio, gdy ich przeciwnicy prawni i sąd wskazali na niespójności w ich badaniach. Kancelaria argumentowała, że ich błąd został popełniony w dobrej wierze, obwiniając bezprecedensowy charakter wykorzystania narzędzi AI w badaniach prawnych. Orzeczenie Castel podkreśliło jednak znaczenie właściwego nadzoru i odpowiedzialności we włączaniu sztucznej inteligencji do praktyk zawodowych.

Robota dla robota? / Przykład porażki chatbota Air Canada

W głośnej sprawie dotyczącej chatbota Air Canada klient Jake Moffatt pozwał linię lotniczą po otrzymaniu nieprawidłowej informacji dotyczącej podróży od asystenta AI. Chodziło o kwestię zwrotu pieniędzy za zakupiony bilet. Po miesiącach konfrontacji z dowodami Air Canada przyznała, że chatbot używał mylących słów i obiecała zaktualizować system. Linie lotnicze początkowo broniły się, twierdząc, że chatbot był odrębnym podmiotem prawnym i nie ponosiły za niego bezpośredniej odpowiedzialności. Członek trybunału Christopher Rivers odrzucił ten argument, podkreślając, że Air Canada jest odpowiedzialna za wszystkie informacje na swojej stronie internetowej, niezależnie od tego, czy pochodzą one ze strony statycznej, czy z chatbota. W rezultacie przewoźnik został zobowiązany do wypłacenia Moffattowi odszkodowania w wysokości 650,88 USD za różnicę w cenie biletu, wraz z dodatkowymi opłatami i odsetkami.

Jak owinąć sobie chatbota wokół palca?

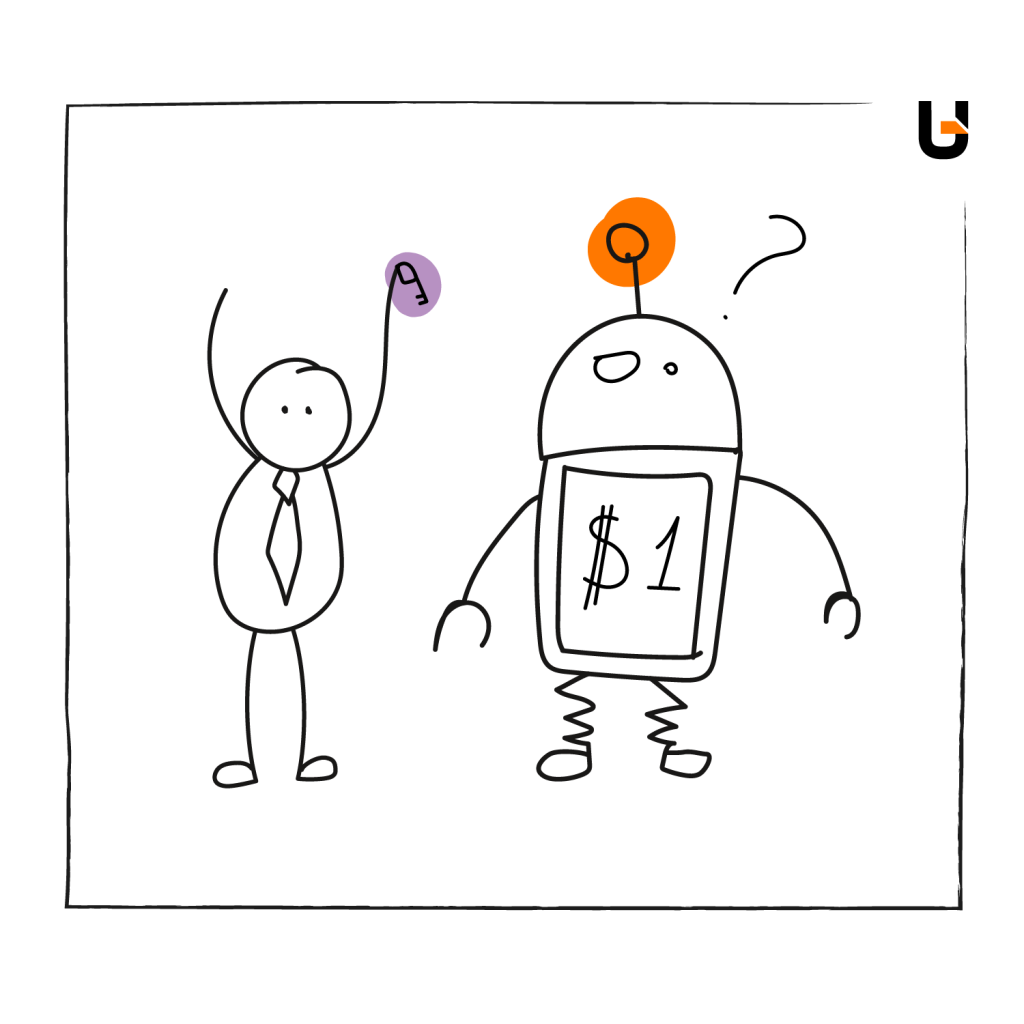

Jeden z godnych uwagi przykładów oszustwa z użyciem chatbota AI dotyczył dowcipnisia, który z powodzeniem zmanipulował chatbota AI pewnego dealera samochodów z Kaliforni, by ten zaoferował mu luksusowy pojazd w absurdalnie niskiej cenie. Incydent, który miał miejsce w salonie GM, pokazał słabości systemów sztucznej inteligencji w środowiskach handlowych o wysokiej stawce. Żartowniś, wykorzystując sprytną i celową manipulację danymi wejściowymi, przekonał chatbota do zaoferowania Chevroleta Tahoe, wycenionego na 76 000 USD, za symboliczną cenę 1 USD. To nadużycie ujawniło, jak łatwo modele AI mogą zostać oszukane przez użytkowników, którzy rozumieją słabości systemu — chatbot polegał wyłącznie na automatycznych odpowiedziach bez porównywania rzeczywistych danych cenowych dealera.

Psikus ten zyskał rozgłos w Internecie, nie tylko podkreślając potencjał oszustwa, ale także stawiając pytania o solidność systemów sztucznej inteligencji w handlu. Podczas gdy chatboty mają na celu usprawnienie obsługi klienta i zapytań sprzedażowych, incydenty takie jak ten podkreślają ich podatność na wykorzystanie.

Zmanipulowana transakcja nigdy nie doszła do skutku, ale dealer musiał się zmierzyć z zadaniem kontroli szkód, co pokazuje, że nawet pozornie nieszkodliwe żarty mogą prowadzić do poważnego ryzyka finansowego, a także utraty twarzy.

Przypadek ten służy jako krytyczne przypomnienie dla firm, aby wdrożyły silniejsze zabezpieczenia w systemach sztucznej inteligencji, w tym ograniczenia automatycznych reakcji i protokoły interwencji człowieka, aby zapobiec podobnym incydentom.

Jak mylą się modele uczenia maszynowego

Siłą napędową systemów sztucznej inteligencji jest uczenie maszynowe (machine learning). Systemy te są tak dobre, jak dane, na których są szkolone. Słabe lub tendencyjne dane treningowe mogą prowadzić do tego, że modele uczenia głębokiego będą generować błędne wyniki. Narzędzia sztucznej inteligencji, takie jak asystenci AI, mogą generować nieprawidłowe wyniki badań prawnych (patrz: wyżej) lub oferować niedokładne podsumowania oparte na wypaczonych informacjach.

Stronniczość (ang. bias) i etyka AI / Kiedy technologia faworyzuje jedną grupę względem drugiej

Stronniczość AI stała się jednym z najbardziej niepokojących wyzwań w systemach sztucznej inteligencji. Dzieje się tak, gdy modele sztucznej inteligencji generują dyskryminujące wyniki, często z powodu uprzedzeń osadzonych w danych szkoleniowych.

Stronniczość w opiece zdrowotnej

Badanie opublikowane przez MIT Technology Review wykazało, że narzędzia AI w opiece zdrowotnej nieproporcjonalnie faworyzowały pacjentów białych w stosunku do czarnych w przewidywaniu potencjalnej potrzeby interwencji medycznej (Uniwersytet Chicago).

Stronniczość w narzędziach rekrutacyjnych

Badanie przeprowadzone przez University of Pennsylvania podkreśla utrzymywanie się uprzedzeń związanych ze sztuczną inteligencją w rekrutacji. Raport mówi, że 40% czarnoskórych specjalistów otrzymało rekomendacje dotyczące pracy oparte na tożsamości, a nie na kwalifikacjach, a 30% otrzymało powiadomienia dotyczące ról poniżej ich poziomu umiejętności. Co więcej, 63% stwierdziło, że rekomendacje akademickie były niższe niż ich rzeczywiste osiągnięcia, co odzwierciedla sposób, w jaki systemy AI mogą utrwalać uprzedzenia rasowe.

Podkreśla to ryzyko związane z osadzaniem uprzedzeń społecznych w platformach rekrutacyjnych, które mogą umniejszać potencjał specjalistów wywodzących się z mniejszości społecznych.

Jak walczyć ze stronniczością w rekrutacji?

Zapewnienie różnorodności wśród zespołów opracowujących te algorytmy i wdrażanie narzędzi takich jak Fairlearn firmy Microsoft może pomóc złagodzić takie uprzedzenia i sprawić, że rekrutacja oparta na sztucznej inteligencji będzie bardziej sprawiedliwa.

Etyka sztucznej inteligencji w podejmowaniu decyzji

Kwestia etyki w systemach sztucznej inteligencji wykracza poza zwykłą stronniczość. Narzędzia sztucznej inteligencji są chętnie wykorzystywane w procesach decyzyjnych: od zatrudniania po zatwierdzanie kredytów. Jednak wiele z tych systemów podejmuje decyzje bez wyraźnej przejrzystości, często w oparciu o błędne lub stronnicze wzorce danych.

Bezpieczeństwo danych / Pięta achillesowa sztucznej inteligencji

Systemy AI oferują przełomowe możliwości, ale generują również poważne wyzwania w zakresie bezpieczeństwa danych. Poleganie na ogromnych ilościach danych – od ustrukturyzowanych po nieustrukturyzowane – oznacza, że jeziora danych i hurtownie danych muszą być skutecznie zabezpieczone, aby zapobiec naruszeniom. Co więcej, błędy w systemach AI mogą prowadzić do szerszych zagrożeń dla bezpieczeństwa, ponieważ są w stanie nieumyślnie ujawniać poufne informacje lub zakłócić działanie podstawowych usług.

Przykład z mediów społecznościowych

Wyraźna ilustracja tych zagrożeń miała miejsce podczas pandemii COVID-19, kiedy platformy mediów społecznościowych, takie jak YouTube, Facebook i X, musiały w dużym stopniu polegać na moderacji opartej na sztucznej inteligencji z powodu braku ludzkich recenzentów. Nagłe przejście na zautomatyzowane systemy administrowania doprowadziło do licznych błędów, w tym bezzasadnego usuwania treści, które nie naruszały zasad. Nie tylko frustrowało to użytkowników, ale także podkreślało, w jaki sposób nadmierne poleganie na sztucznej inteligencji może tworzyć luki w zabezpieczeniach, w których niewłaściwie ocenione przetwarzanie danych lub działania moderacyjne mogą nieumyślnie podważyć zarówno bezpieczeństwo, jak i zaufanie użytkowników.

Potencjał sztucznej inteligencji w świecie sportu

AI szybko przekształca również branżę sportową. Jedną z bardziej intrygujących możliwości są treści (content marketing) generowane przez sztuczną inteligencję, które mogą zrewolucjonizować sposób, w jaki fani angażują się w wydarzenia sportowe.

Dzięki wykorzystaniu technologii sztucznej inteligencji, wywiady pomeczowe i konferencje prasowe mogłyby stać się bardziej interaktywne, umożliwiając fanom zadawanie pytań i otrzymywanie realistycznych, opartych na sztucznej inteligencji odpowiedzi od swoich ulubionych graczy. Chociaż możliwości głębszego zaangażowania fanów i wciągających doświadczeń dzięki AI działają na wyobraźnię, wiążą się również z potencjalnym ryzykiem – szczególnie w zakresie rozprzestrzeniania się dezinformacji (fake news, deep fake), jeśli nie są uważnie monitorowane.

Fałszywa konferencja prasowa Klaya Thompsona z wykorzystaniem AI

Niedawny przykład możliwości sztucznej inteligencji – i związanych z nią zagrożeń – pojawił się w przypadku gwiazdy NBA, Klaya Thompsona (wówczas Golden State Warriors, obecnie Dallas Mavericks). Wygenerowane przez sztuczną inteligencję wideo z fałszywej konferencji prasowej z udziałem Thompsona zaczęło krążyć w Internecie wśród fanów, którzy uwierzyli, że jest ono prawdziwe. Thompson niespodziewanie ogłosił swój transfer do ligi tajwańskiej, co zaszokowało opinię publiczną. Deep fake był imponująco realistyczny, pokazując, jak zaawansowana stała się sztuczna inteligencja w replikowaniu ludzkiej mowy oraz mimiki. Uwidocznił jednocześnie ciemniejszą stronę tej technologii: potencjał tworzenia przekonujących, ale do cna fałszywych treści.

Incydent ten mówi wiele o potrzebie wytycznych etyki i ścisłego monitorowania, aby zapobiec wykorzystywaniu sztucznej inteligencji do rozpowszechniania dezinformacji w mediach sportowych – i nie tylko (więcej informacji nt. w/w przypadku tutaj).

Sztuczna inteligencja w wykrywaniu oszustw / Obietnice i pułapki

Systemy AI wykazują się skutecznością w wykrywaniu oszustw (Fraud Detection), przetwarzając duże ilości danych w czasie rzeczywistym w celu oznaczenia podejrzanych transakcji. Zapewniają one ciągłą ochronę przed ewoluującymi taktykami oszustów. W dynamicznie rozwijających się sektorach, takich jak e-commerce, gdzie wolumen transakcji może przytłoczyć manualne monitorowanie, sztuczna inteligencja odgrywa kluczową rolę w wykrywaniu anomalii. Jednak pomimo tych zalet systemy wykrywania oszustw bazujące na sztucznej inteligencji napotykają ograniczenia – szczególnie w przypadku fałszywych alarmów.

Wyzwanie związane z fałszywymi alarmami

Jednym z głównych problemów związanych z wykrywaniem oszustw za pomocą sztucznej inteligencji są fałszywe alarmy, w których legalne transakcje są niesłusznie oznaczane jako oszukańcze (fraudulent). Takie sytuacje frustrują klientów i prowadzą do strat finansowych dla firm. Badania MIT pokazują, że tradycyjne modele mają często niską dokładność (niektóre szacunki sugerują, że tylko jeden na pięć wskaźników sukcesu w przewidywaniu oszustw, powodując niepotrzebne blokady transakcji). W 2018 r. amerykańscy sprzedawcy e-commerce stracili 2 miliardy dolarów z powodu tych fałszywych alertów, zrażając klientów i niszcząc relacje biznesowe.

Skutki stronniczości w systemach sztucznej inteligencji

Systemy wykrywania oszustw oparte o AI mogą również wykazywać stronniczość, zwłaszcza gdy są szkolone na podstawie wadliwych danych. Jeśli określone grupy demograficzne są nieproporcjonalnie często oznaczane jako podejrzane, może to wywołać społeczne oburzenie, a także skutkować problemami prawnymi. Te uprzedzenia nie tylko stwarzają ryzyko utraty reputacji, ale także budzą obawy etyczne dotyczące sposobu, w jaki sztuczna inteligencja jest opracowywana i wykorzystywana do wykrywania oszustw. Brak przejrzystości w podejmowaniu decyzji przez sztuczną inteligencję tylko pogarsza te kwestie.

Równoważenie dokładności, uczciwości, wydajności

Postępy w wykrywaniu oszustw przez sztuczną inteligencję muszą równoważyć dokładność i uczciwość. Naukowcy z MIT opracowali model, który zmniejszył liczbę fałszywych alarmów o 54%, potencjalnie oszczędzając organizacjom 190 000 euro rocznie. Korzystanie z różnorodnych danych o wysokiej jakości oraz zaawansowanego uczenia maszynowego poprawia wydajność AI. Nadzór ludzki i regularne audyty zapewniają skuteczne zapobieganie oszustwom przy jednoczesnym minimalizowaniu zakłóceń w legalnych transakcjach, chroniąc w ten sposób zarówno reputacje firm, jak i budując zaufanie klientów.

Niebezpieczeństwo zbyt dużego zaufania wobec generatywnej sztucznej inteligencji

Obawy o zastąpienie miejsc pracy przez sztuczną inteligencję i uprzedzenia w rekrutacji są ze sobą ściśle powiązane, odzwierciedlając szerszy sceptycyzm co do niezawodności AI i jej wpływu na ludzkie role. Strach przed automatyzacją wynika z niepowodzeń sztucznej inteligencji w dokładnym powielaniu skomplikowanych ludzkich osądów, utrwalając przez to różnego rodzaju uprzedzenia i błędy. Owe kwestie budzą wątpliwość, czy sztuczna inteligencja jest rzeczywiście w stanie zastąpić ludzkie role na większą skalę. Poprawa uczciwości i dokładności systemów sztucznej inteligencji jest niezbędna przed powierzeniem im zadań, które mają znaczący wpływ na życie i utrzymanie ludzi.

Automatyzacja budzi obawy o miejsca pracy

Wykorzystanie narzędzi sztucznej inteligencji w sektorze produkcyjnym, takich jak inteligentne roboty transportowe i zautomatyzowane pojazdy kierowane, doprowadziło do obaw o utratę miejsc pracy, zwłaszcza wśród pracowników fizycznych. Technologie AI mogą wypełniać zadania tradycyjnie wykonywane przez ludzi, takie jak kontrola jakości i konserwacja, powodując obawy o zastąpienie miejsc pracy w branżach, które w dużym stopniu polegają na ludzkiej wiedzy. Choć generatywna sztuczna inteligencja zwiększa produktywność, często spotyka się z oporem, gdy pracownicy czują się zagrożeni automatyzacją, co podkreśla złożoność integracji sztucznej inteligencji z rzeczywistą dynamiką pracy.

Rola danych treningowych: jak sobie pościelesz, tak się wyśpisz

Jednym z najważniejszych czynników stojących za niepowodzeniami sztucznej inteligencji są niskiej jakości dane treningowe. Bez wyczyszczonych, dokładnych i reprezentatywnych danych nawet najlepsze systemy sztucznej inteligencji mogą dawać błędne wyniki.

Aby firmy mogły z powodzeniem wdrażać narzędzia sztucznej inteligencji, muszą upewnić się, że ich modele AI są szkolone przy użyciu wysokiej jakości danych. Wprowadzające w błąd lub tendencyjne dane mogą skutkować poważnymi awariami, szczególnie w krytycznych sektorach, takich jak opieka zdrowotna, pojazdy autonomiczne i badania prawne.

O kluczowej roli zrozumienia, przygotowania i modelowania danych pisaliśmy w tym artykule.

Jak bezpieczeństwo danych wpływa na wydajność AI

W miarę gdy coraz więcej firm wdraża systemy sztucznej inteligencji, bezpieczeństwo danych staje się coraz bardziej palącym problemem. Jeśli dane treningowe wykorzystywane przez narzędzia AI nie są odpowiednio zabezpieczone, ryzyko cyberataków i wycieku danych rośnie wykładniczo. Naruszone dane mogą narazić na szwank reputację firmy i doprowadzić do nałożenia na nią kar regulacyjnych.

Ochrona AI dzięki bezpiecznemu przechowywaniu danych

Przedsiębiorstwa powinny inwestować w bezpieczne rozwiązania do magazynowania danych, zapewniając ich bezpieczne przechowywanie w formie ustrukturyzowanej i nieustrukturyzowanej. Pomoże to zmniejszyć ryzyko ataków cybernetycznych i zapewni bezpieczeństwo procesom AI.

Wnioski: zrównoważone podejście do sztucznej inteligencji

Mimo że narzędzia AI oferują ogromny potencjał, konieczne jest rozpoznanie ich ograniczeń. Przyszłość sztucznej inteligencji zależy od naszej zdolności do skutecznego zarządzania tymi systemami. Kluczowym elementem jest zapewnienie, że modele AI są trenowane na wysokiej jakości danych i chronione przed zagrożeniami zarówno wewnętrznymi, jak i zewnętrznymi. Stawiając na pierwszym miejscu bezpieczeństwo danych oraz integralność modeli, biznes może uniknąć wielu powszechnych pułapek i w pełni wykorzystać możliwości AI – w odpowiedzialny sposób.

Rozwiązywanie problemów AI: Od etyki po cyberbezpieczeństwo

Rozwiązywanie problemów związanych z AI jest istotne z perspektywy przygotowania infrastruktury danych, cyberbezpieczeństwa oraz etyki. Mimo że AI optymalizuje procesy i obniża koszty, niesie też ze sobą ryzyko, takie jak uprzedzenia w danych, niska ich jakość oraz zagrożenia cybernetyczne. W rezultacie niepowodzenia mogą prowadzić do poważnych konsekwencji, co podkreśla potrzebę nieustannego ludzkiego nadzoru i regularnego monitorowania procesów związanych z AI.